Pada artikel selanjutnya kita akan melihat Wget. Harus dikatakan bahwa GNU Wget adalah a alat gratis yang memungkinkan pengunduhan konten dari server web dengan cara yang sederhana dan cepat. Namanya berasal dari World Wide Web (w) dan kata get (dalam bahasa Inggris mendapatkan). Nama ini berarti: dapatkan dari WWW.

Saat ini ada lusinan aplikasi untuk mengunduh file dengan sangat efisien. Kebanyakan dari mereka didasarkan pada antarmuka web dan desktop, dan dikembangkan untuk semua sistem operasi. Namun di Gnu / Linux (ada juga versi untuk Windows) ada pengelola unduhan yang kuat dari file wget. Itu dianggap sebagai pengunduh paling kuat yang ada. Mendukung protokol seperti http, https dan ftp.

Unduh file dengan wget

Unduh file

Cara termudah untuk menggunakan alat ini adalah dengan mengunduh menunjukkan file tersebut Apa yang kita inginkan:

wget http://sitioweb.com/programa.tar.gz

Unduh menggunakan protokol berbeda

Sebagai pengelola unduhan yang baik, itu mungkin meminta lebih dari satu unduhan sekaligus. Kami bahkan dapat menggunakan protokol yang berbeda dalam urutan yang sama:

wget http://sitioweb.com/programa.tar.gz ftp://otrositio.com/descargas/videos/archivo-video.mpg

Unduh dengan ekstensi

Cara lain untuk mengunduh banyak file file yang menggunakan ekstensi yang sama, itu akan menggunakan tanda bintang wildcard:

wget<code class="language-bash" data-lang="bash">-r -A.pdf</code>http://sitioweb.com/*.pdf

Perintah ini tidak selalu berfungsi, karena beberapa server mungkin telah memblokir akses ke wget.

Unduh daftar file

Jika yang kami inginkan adalah mengunduh file yang kami temukan, kami hanya perlu menyimpannya URL dalam file. Kami akan membuat daftar bernama files.txt dan kami akan menunjukkan nama daftar ke perintah. Perlu tempatkan hanya satu url per baris di dalam files.txt.

Perintah yang akan kita gunakan untuk mengunduh daftar yang dibuat dan yang kita simpan dalam file .txt adalah sebagai berikut:

wget -i archivos.txt

Mulai ulang unduhan

Jika karena alasan apa pun unduhan terputus, kami akan dapat melakukannya melanjutkan pengunduhan dari tempatnya berhenti menggunakan opsi c dengan perintah wget:

wget -i -c archivos.txt

Tambahkan log tentang unduhan

Jika kami ingin mendapatkan log tentang unduhan, agar mengontrol insiden apa pun di atasnya, kita harus menambahkan opsi -o seperti yang ditunjukkan berikut ini:

wget -o reporte.txt http://ejemplo.com/programa.tar.gz

Batasi bandwidth unduhan

Dalam unduhan yang sangat lama kami bisa batasi bandwidth unduhan. Dengan ini, kami akan mencegah pengunduhan menghabiskan semua bandwidth selama pengunduhan:

wget -o /reporte.log --limit-rate=50k ftp://ftp.centos.org/download/centos5-dvd.iso

Unduh dengan nama pengguna dan kata sandi

Jika kita ingin mengunduh dari situs di mana nama pengguna / kata sandi diperlukan, kita hanya perlu menggunakan opsi ini:

wget --http-user=admin --http-password=12345 http://ejemplo.com/archivo.mp3

Download upaya

Default, Program ini melakukan 20 upaya untuk membuat koneksi dan mulai mengunduh, di situs yang sangat jenuh mungkin bahkan dengan 20 upaya itu tidak tercapai. Dengan opsi t meningkat menjadi lebih banyak upaya.

wget -t 50 http://ejemplo.com/pelicula.mpg

Unduh situs web dengan wget

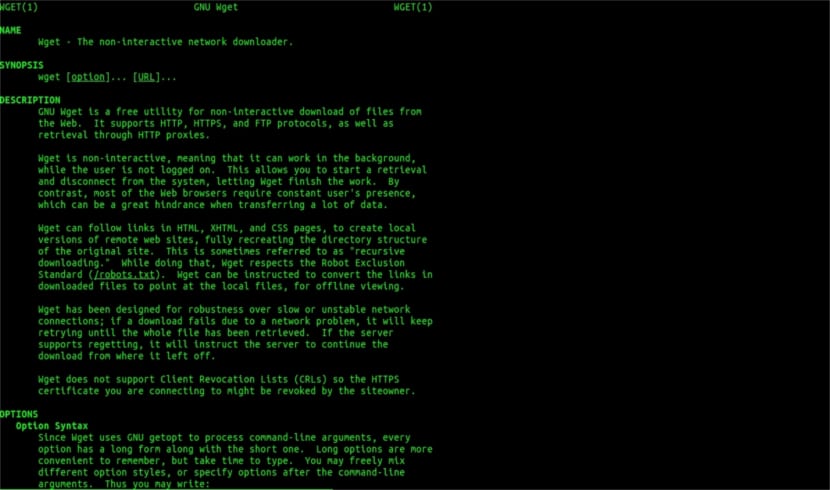

Dapatkan bantuan pria

Wget tidak terbatas hanya pada unduhan fileKami dapat mengunduh satu halaman penuh. Kami hanya perlu menulis sesuatu seperti:

wget www.ejemplo.com

Unduh situs web dan elemen tambahannya

Dengan opsi p kami juga akan mengunduh semua file elemen tambahan yang dibutuhkan di halaman seperti lembar gaya, gambar sebaris, dll.

Jika kita menambahkan opsi r se akan mengunduh secara rekursif hingga 5 level dari situs:

wget -r www.ejemplo.com -o reporte.log

Konversikan tautan ke lokal

Secara default, link di dalam situs mengarah ke alamat seluruh domain. Jika kita mengunduh situs secara rekursif dan kemudian mempelajarinya secara offline, kita dapat menggunakan opsi konversi-tautan yang akan mengubahnya menjadi tautan lokal:

wget --convert-links -r http://www.sitio.com/

Dapatkan salinan lengkap situs ini

Kami akan memiliki kemungkinan untuk mendapatkan salinan lengkap dari sebuah situs. Itu –Pilihan cermin sama dengan menggunakan opsi -r -l inf -N yang menunjukkan rekursi pada tingkat tak terbatas dan mendapatkan stempel waktu asli dari setiap file yang diunduh.

wget --mirror http://www.sitio.com/

Ubah ekstensi

Jika Anda mengunduh seluruh situs untuk melihatnya secara offline, beberapa file yang diunduh mungkin tidak dapat dibuka, karena ekstensi seperti .cgi, .asp, atau .php. Kemudian dimungkinkan untuk menunjukkan dengan –Html-opsi ekstensi Semua file diubah menjadi ekstensi .html.

wget --mirror --convert-links --html-extension http://www.ejemplo.com

Ini hanyalah pedoman umum daripada yang dapat Anda lakukan dengan Wget. Siapapun yang ingin dapat berkonsultasi dengan panduan online untuk berkonsultasi dengan semua kemungkinan yang ditawarkan pengelola unduhan yang luar biasa ini kepada kami.

Mengenai "Unduh dengan ekstensi", saya berhenti membaca. Anda tidak dapat mengunduh apa yang tidak Anda ketahui. Kecuali jika direktori yang diminta mengizinkan daftar file dan tidak memiliki indeks (dan keduanya harus terjadi pada saat yang sama), apa yang Anda katakan tidak dapat dilakukan. Level yang luar biasa.

Halo Rubén, ketidaktahuan itu agak berani.

Komentar Anda dapat dilakukan dengan perintah sederhana ke google:

tipe file:situs pdf:ubunlog.com

Dalam contoh ini tidak ada pdf di blog ini, tetapi ubah domain di akhir menjadi web yang Anda sukai dan Anda akan melihat betapa mudahnya melihat semua file dari suatu jenis web.

Semoga harimu menyenangkan.

Tetapi wget tidak terhubung ke google untuk menemukan pdf yang ada di url. Direktori web harus terbuka dan harus ada halaman indeks yang dibuat oleh mod_autoindex atau yang serupa, seperti yang dikatakan Rubén Cardenal.

"Perintah ini tidak selalu berfungsi, karena beberapa server mungkin telah memblokir akses ke wget."

Amandemen ini ditempatkan pada artikel ini, karena saya tidak setuju dengan itu (meskipun secara teknis dimungkinkan untuk memblokir agen web tertentu untuk permintaan header http dan mengembalikan pesan 403 "tidak diizinkan") dan saya akan menjelaskan alasannya:

Semua server web Apache (dan saya sedang berbicara tentang persentase yang cukup besar dari server) secara default mengizinkan globbing (artikel Wikipedia yang sangat baik, baca: https://es.wikipedia.org/wiki/Glob_(inform%C3%A1tica) .

Ini dalam praktiknya berarti, seperti yang ditentukan oleh mr. Rubén (dan dia benar), JIKA TIDAK ADA FILE YANG DIPANGGIL "index.php" atau "index.html" (atau bahkan hanya disebut "index") server diam-diam akan mengembalikan daftar file dan direktori (tentu saja dalam bentuk dari halaman html dengan informasi sebagai tautan web untuk setiap file). KEBANYAKAN WEB SERVICE MENONAKTIFKAN FITUR INI MELALUI FILE .htacces (tepatnya Apache2) UNTUK ALASAN KEAMANAN.

Inilah keserbagunaan wget (lihat ceritanya, sekali lagi di Wikipedia, yang paling Anda ketahui: https://es.wikipedia.org/wiki/GNU_Wget ) untuk menganalisis atau "mengurai" informasi semacam itu dan mengekstrak hanya ekstensi yang kami minta.

Sekarang, jika ini tidak berfungsi, karena satu dan lain alasan, kita dapat mencoba fungsi wget tingkat lanjut lainnya, saya mengutip langsung dalam bahasa Inggris:

Anda ingin mengunduh semua GIF dari direktori di server HTTP. Anda mencoba 'wget http://www.example.com/dir/*.gif’, tapi itu tidak berhasil karena pengambilan HTTP tidak mendukung GLOBBING (saya beri huruf kapital). Dalam hal ini, gunakan:

wget -r -l1 –tidak-orang tua -A.gif http://www.example.com/dir/

Lebih bertele-tele, tetapi efeknya sama. '-r -l1' berarti mengambil secara rekursif (lihat Download Rekursif), dengan kedalaman maksimum 1. '–no-parent' berarti referensi ke direktori induk diabaikan (lihat Batas Berbasis Direktori), dan '-A. gif 'berarti mengunduh hanya file GIF. '-A «* .gif»' akan berhasil juga.

JIKA ANDA BERJALAN DENGAN CARA TERAKHIR INI wget akan membuat folder untuk kita dengan alamat web yang diminta di folder default tempat kita bekerja, dan itu akan membuat subdirektori jika perlu dan di sana akan ditempatkan, misalnya, gambar .gif yang kita gunakan. permintaan.

--------

NAMUN jika masih tidak mungkin untuk mendapatkan hanya jenis file tertentu (* .jpg, misalnya) kita harus menggunakan parameter «–halaman-syarat» yang mendownload semua elemen internal halaman html (gambar, suara, css, dll) bersama-sama dengan halaman html itu sendiri ("–page-Requisites" dapat disingkat "-p") dan itu akan sama dengan mendownload sesuatu seperti "mhtml" https://tools.ietf.org/html/rfc2557

Semoga informasi ini bermanfaat bagi Anda.

Terima kasih atas catatannya. Salu2.

Saya pikir Anda mengalami kesalahan, dua baris pertama memiliki perintah yang sama.

Terima kasih banyak, tutorial yang sangat bagus!