다음 기사에서 우리는 Wget을 살펴볼 것입니다. GNU Wget은 무료 도구 웹 서버에서 콘텐츠를 다운로드 할 수 있습니다. 간단하고 빠른 방법으로. 이름은 World Wide Web (w) 및 단어 get (영어 얻을). 이 이름은 다음을 의미합니다. WWW에서 얻다.

오늘날에는 파일을 매우 효율적으로 다운로드 할 수있는 수십 개의 응용 프로그램이 있습니다. 대부분은 웹 및 데스크톱 인터페이스를 기반으로하며 모든 운영 체제 용으로 개발되었습니다. 그러나 Gnu / Linux (Windows 용 버전도 있습니다.) 있습니다 강력한 다운로드 관리자 wget 파일의. 존재하는 가장 강력한 다운로더로 간주됩니다. http, https 및 같은 프로토콜 지원 FTP.

wget으로 파일 다운로드

파일 다운로드

이 도구를 사용하는 가장 간단한 방법은 파일을 나타내는 우리가 원하는 것:

wget http://sitioweb.com/programa.tar.gz

다른 프로토콜을 사용하여 다운로드

좋은 다운로드 관리자로서 가능합니다. 한 번에 두 개 이상의 다운로드 요청. 같은 순서로 다른 프로토콜을 사용할 수도 있습니다.

wget http://sitioweb.com/programa.tar.gz ftp://otrositio.com/descargas/videos/archivo-video.mpg

확장으로 다운로드

여러 다운로드하는 또 다른 방법 동일한 확장자를 사용하는 파일, 와일드 카드 별표를 사용합니다.

wget<code class="language-bash" data-lang="bash">-r -A.pdf</code>http://sitioweb.com/*.pdf

이 명령은 일부 서버에 대한 액세스를 차단했을 수 있으므로 항상 작동하지는 않습니다. wget.

파일 목록 다운로드

찾고있는 파일을 다운로드하려는 경우 파일을 저장하기 만하면됩니다. 파일의 URL. 우리는라는 목록을 만들 것입니다 files.txt 그리고 목록의 이름을 명령에 표시합니다. 필요한 한 줄에 하나의 URL 만 배치 files.txt 내부.

생성 된 목록을 다운로드하고 .txt 파일에 저장하는 데 사용할 명령은 다음과 같습니다.

wget -i archivos.txt

다운로드 다시 시작

어떤 이유로 든 다운로드가 중단 된 경우 다음을 수행 할 수 있습니다. 중단 된 부분부터 계속 다운로드 사용하여 옵션 c wget 명령으로 :

wget -i -c archivos.txt

다운로드에 대한 로그 추가

다운로드에 대한 로그를 얻으려면 사건을 통제하다 그것에, 우리는 추가해야 할 것입니다 -o 옵션 다음과 같이 표시됩니다.

wget -o reporte.txt http://ejemplo.com/programa.tar.gz

다운로드 대역폭 제한

매우 긴 다운로드에서 우리는 다운로드 대역폭 제한. 이를 통해 다운로드가 다운로드 기간 동안 모든 대역폭을 차지하는 것을 방지 할 수 있습니다.

wget -o /reporte.log --limit-rate=50k ftp://ftp.centos.org/download/centos5-dvd.iso

사용자 이름과 비밀번호로 다운로드

사용자 이름 / 비밀번호가 필요한 사이트에서 다운로드하려는 경우 다음 옵션 만 사용하면됩니다.

wget --http-user=admin --http-password=12345 http://ejemplo.com/archivo.mp3

다운로드 시도

기본, 이 프로그램은 연결 설정을 20 번 시도합니다. 매우 포화 된 사이트에서는 20 번의 시도도 성공하지 못했을 수 있습니다. 이랑 옵션 t 더 많은 시도로 증가합니다.

wget -t 50 http://ejemplo.com/pelicula.mpg

wget으로 웹 사이트 다운로드

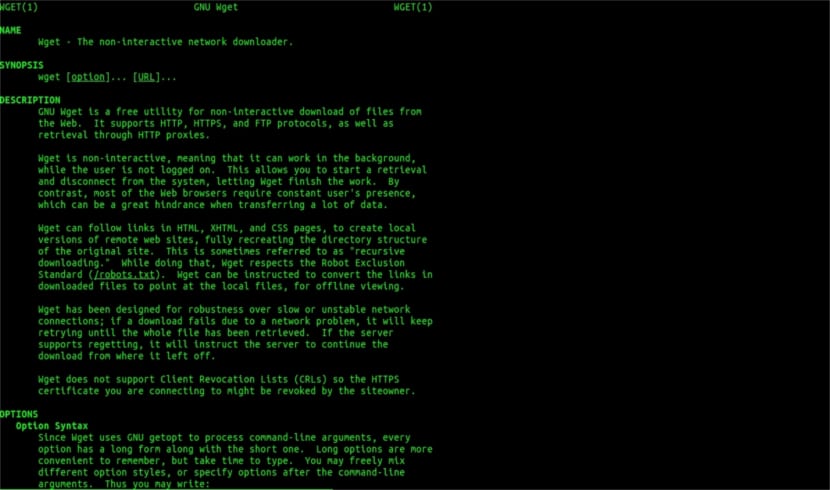

WGET 도움말 맨

Wget은 파일 다운로드에만 국한되지 않습니다.전체 페이지를 다운로드 할 수 있습니다. 다음과 같이 작성하면됩니다.

wget www.ejemplo.com

웹 사이트 및 추가 요소 다운로드

와 옵션 p 우리는 또한 모든 페이지에 필요한 추가 요소 스타일 시트, 인라인 이미지 등

추가하면 옵션 r se 최대 5 단계까지 재귀 적으로 다운로드됩니다. 사이트에서 :

wget -r www.ejemplo.com -o reporte.log

링크를 로컬로 변환

기본적으로 사이트 내의 링크는 전체 도메인의 주소를 가리 킵니다. 사이트를 재귀 적으로 다운로드 한 다음 오프라인으로 학습하면 링크 변환 옵션 그것은 그들을 바꿀 것입니다 로컬 링크:

wget --convert-links -r http://www.sitio.com/

사이트의 전체 사본 받기

우리는 사이트의 완전한 사본을 얻을 수 있습니다. 그만큼 – 미러 옵션 사용하는 것과 동일합니다 옵션 -r -l inf -N 무한 수준의 재귀를 나타내며 다운로드 한 각 파일의 원래 타임 스탬프를 얻습니다.

wget --mirror http://www.sitio.com/

변환 확장

전체 사이트를 다운로드하여 오프라인으로 보는 경우 .cgi, .asp 또는 .php와 같은 확장자로 인해 다운로드 한 여러 파일이 열리지 않을 수 있습니다. 그런 다음 –html- 확장 옵션 모든 파일은 .html 확장자로 변환됩니다.

wget --mirror --convert-links --html-extension http://www.ejemplo.com

이것은 일반적인 지침 일뿐입니다. Wget으로 할 수있는 것보다. 누구든지 상담 할 수 있습니다 온라인 매뉴얼 이 멋진 다운로드 관리자가 우리에게 제공하는 모든 가능성을 참조하십시오.

"확장 프로그램으로 다운로드"에 관해서는 읽기를 중단했습니다. 모르는 것은 다운로드 할 수 없습니다. 요청 된 디렉토리가 파일 목록을 허용하고 색인이없는 경우 (둘 다 동시에 발생해야 함), 말한 것은 수행 할 수 없습니다. 어떤 수준.

안녕하세요 루벤, 무지는 약간 대담합니다.

댓글은 Google에 간단한 명령으로 수행 할 수 있습니다.

파일 형식:pdf 사이트:ubunlog.COM

이 예에서는이 블로그에 pdf가 없지만 원하는 웹으로 끝에서 도메인을 변경하면 웹 유형의 모든 파일을 보는 것이 얼마나 쉬운 지 알 수 있습니다.

좋은 하루 되세요.

그러나 wget은 url에있는 pdf를 찾기 위해 google에 연결하지 않습니다. 웹 디렉토리는 열려 있어야하며 Rubén Cardenal이 말한 것처럼 mod_autoindex 또는 이와 유사한 것으로 생성 된 색인 페이지가 있어야합니다.

"일부 서버가 wget에 대한 액세스를 차단했을 수 있으므로이 명령이 항상 작동하는 것은 아닙니다."

(기술적으로는 http 헤더 요청에 대해 특정 웹 에이전트를 차단하고 403 "허용되지 않음"메시지를 반환 할 수 있지만) 동의하지 않기 때문에이 문서에 적용된이 수정안은 다음과 같은 이유를 설명합니다.

모든 Apache 웹 서버 (그리고 상당한 비율의 서버에 대해 이야기하고 있습니다)는 기본적으로 글 로빙을 허용합니다 (훌륭한 Wikipedia 기사, 읽기 : https://es.wikipedia.org/wiki/Glob_(inform%C3%A1tica) .

이것은 실제로 mr. Rubén (그리고 그가 옳습니다), "index.php"또는 "index.html"(또는 단순히 "index"라고도 함)이라고 부르는 파일이 없으면 서버는 조용히 파일 및 디렉토리 목록 (물론 형식으로)을 반환합니다. 각 파일에 대한 웹 링크로 정보가있는 html 페이지). 대부분의 웹 서버는 보안상의 이유로 .htacces 파일 (엄격히 말하자면 Apache2)을 통해이 기능을 비활성화합니다.

다음은 wget의 다재다능한 기능입니다 (가장 잘 아는 Wikipedia에서 그의 이야기를 다시 참조하십시오.) https://es.wikipedia.org/wiki/GNU_Wget ) 상기 정보를 분석 또는 "파싱"하고 우리가 요청하는 확장 만 추출합니다.

이제 어떤 이유로 든 작동하지 않는 경우 wget의 다른 고급 기능을 사용해 볼 수 있습니다. 영어로 직접 인용합니다.

HTTP 서버의 디렉토리에서 모든 GIF를 다운로드하려고합니다. 당신은 'wget http://www.example.com/dir/*.gif’,하지만 HTTP 검색이 GLOBBING을 지원하지 않기 때문에 작동하지 않았습니다 (대문자를 넣었습니다). 이 경우 다음을 사용하십시오.

wget -r -l1 – 부모 없음 -A.gif http://www.example.com/dir/

더 장황하지만 효과는 동일합니다. '-r -l1'은 최대 깊이가 1 인 재귀 적 검색 (재귀 적 다운로드 참조)을 의미합니다. '–no-parent'는 상위 디렉토리에 대한 참조가 무시됨을 의미하며 (디렉토리 기반 제한 참조) '-A. gif '는 GIF 파일 만 다운로드하는 것을 의미합니다. '-A«* .gif»'도 작동했을 것입니다.

이 마지막 방법으로 실행되는 경우 wget은 작업중인 기본 폴더에 요청 된 웹 주소로 폴더를 만들고 필요한 경우 하위 디렉터리를 만들고 거기에 .gif 이미지를 배치합니다. 요청합니다.

--------

그러나 여전히 특정 종류의 파일 (예 : * .jpg) 만 얻을 수없는 경우 html 페이지의 모든 내부 요소 (이미지, 사운드, 파일)를 다운로드하는«–page-requisites»매개 변수를 사용해야합니다. css 등)과 html 페이지 자체 ( "–page-requisites"는 "-p"로 축약 할 수 있음)와 함께 "mhtml"과 같은 것을 다운로드하는 것과 같습니다. https://tools.ietf.org/html/rfc2557

이 정보가 도움이 되었기를 바랍니다.

메모 감사합니다. 살루 2.

오류가 있다고 생각합니다. 처음 두 줄에는 동일한 명령이 있습니다.

대단히 감사합니다, 아주 좋은 튜토리얼!