În articolul următor vom analiza Wget. Trebuie spus că GNU Wget este un instrument gratuit care permite descărcarea conținutului de pe serverele web într-un mod simplu și rapid. Numele său derivă din World Wide Web (w) și cuvântul get (în engleză obține). Acest nume vine să însemne: obține de la WWW.

Astăzi există zeci de aplicații pentru a descărca fișiere foarte eficient. Cele mai multe dintre ele se bazează pe interfețe web și desktop și sunt dezvoltate pentru toate sistemele de operare. Cu toate acestea, pe Gnu / Linux (există și o versiune pentru Windows) există puternic manager de descărcare de fișiere wget. Este considerat cel mai puternic program de descărcare care există. Suportă protocoale precum http, https și ftp.

Descărcați fișiere cu wget

Descărcați un fișier

Cel mai simplu mod de a utiliza acest instrument este să descărcați indicând dosarul Ceea ce vrem:

wget http://sitioweb.com/programa.tar.gz

Descărcați folosind diferite protocoale

Ca un bun manager de descărcare, este posibil solicitați mai multe descărcări odată. Putem folosi chiar și protocoale diferite în aceeași ordine:

wget http://sitioweb.com/programa.tar.gz ftp://otrositio.com/descargas/videos/archivo-video.mpg

Descărcați prin extensie

Un alt mod de a descărca mai multe fișiere care utilizează aceeași extensie, va folosi asteriscul comodin:

wget<code class="language-bash" data-lang="bash">-r -A.pdf</code>http://sitioweb.com/*.pdf

Această comandă nu funcționează întotdeauna, deoarece este posibil ca unele servere să fi blocat accesul la wget.

Descărcați o listă de fișiere

Dacă ceea ce dorim este să descărcăm fișierele pe care le găsim, va trebui doar să le salvăm URL într-un fișier. Vom crea o listă numită files.txt și vom indica numele listei la comandă. Necesar plasați o singură adresă URL pe linie în fișiere.txt.

Comanda pe care o vom folosi pentru a descărca lista creată și pe care o salvăm în fișiere .txt va fi următoarea:

wget -i archivos.txt

Reporniți o descărcare

Dacă din orice motiv descărcarea a fost întreruptă, vom putea continuați descărcarea de unde a rămas folosind opțiunea c cu comanda wget:

wget -i -c archivos.txt

Adăugați un jurnal despre descărcare

Dacă dorim să obținem un jurnal despre descărcare, pentru a controlează orice incident pe el, va trebui să adăugăm -o opțiune așa cum se arată în următoarele:

wget -o reporte.txt http://ejemplo.com/programa.tar.gz

Limitați lățimea de bandă a descărcării

În descărcările foarte lungi putem limitați lățimea de bandă a descărcării. Cu aceasta vom împiedica descărcarea să preia toată lățimea de bandă pe durata descărcării:

wget -o /reporte.log --limit-rate=50k ftp://ftp.centos.org/download/centos5-dvd.iso

Descărcați cu numele de utilizator și parola

Dacă dorim să descărcăm de pe un site unde este necesar un nume de utilizator / o parolă, va trebui să folosim doar aceste opțiuni:

wget --http-user=admin --http-password=12345 http://ejemplo.com/archivo.mp3

Încercări de descărcare

Mod implicit, acest program face 20 de încercări de stabilire a conexiunii și începeți descărcarea, pe site-urile foarte saturate este posibil ca nici măcar cu 20 de încercări să nu se fi realizat. Cu opțiunea t crește la mai multe încercări.

wget -t 50 http://ejemplo.com/pelicula.mpg

Descărcați un site web cu wget

Ajută omul

Wget nu se limitează doar la descărcări de fișiereVom putea descărca o pagină completă. Va trebui doar să scriem ceva de genul:

wget www.ejemplo.com

Descărcați un site web și elementele sale suplimentare

Cu opțiunea p vom descărca, de asemenea, toate fișierele elemente suplimentare necesare pe pagină precum foi de stil, imagini în linie etc.

Dacă adăugăm opțiunea r se va descărca recursiv până la 5 niveluri de pe site:

wget -r www.ejemplo.com -o reporte.log

Convertiți linkurile în local

În mod implicit, linkurile din cadrul site-ului indică adresa întregului domeniu. Dacă descărcăm site-ul recursiv și apoi îl studiem offline, putem folosi opțiunea convert-links asta îi va transforma în linkuri locale:

wget --convert-links -r http://www.sitio.com/

Obțineți o copie completă a site-ului

Vom avea posibilitatea de a obține o copie completă a unui site. –Opțiunea oglindă este la fel ca și utilizarea opțiuni -r -l inf -N care indică recursivitate la nivel infinit și obținerea marcajului de timp original al fiecărui fișier descărcat.

wget --mirror http://www.sitio.com/

Transformă extensiile

Dacă descărcați întregul site pentru a-l vizualiza offline, este posibil ca mai multe fișiere descărcate să nu se deschidă, din cauza extensiilor precum .cgi, .asp sau .php. Apoi este posibil să indicați cu –Html-opțiune de extensie Toate fișierele sunt convertite într-o extensie .html.

wget --mirror --convert-links --html-extension http://www.ejemplo.com

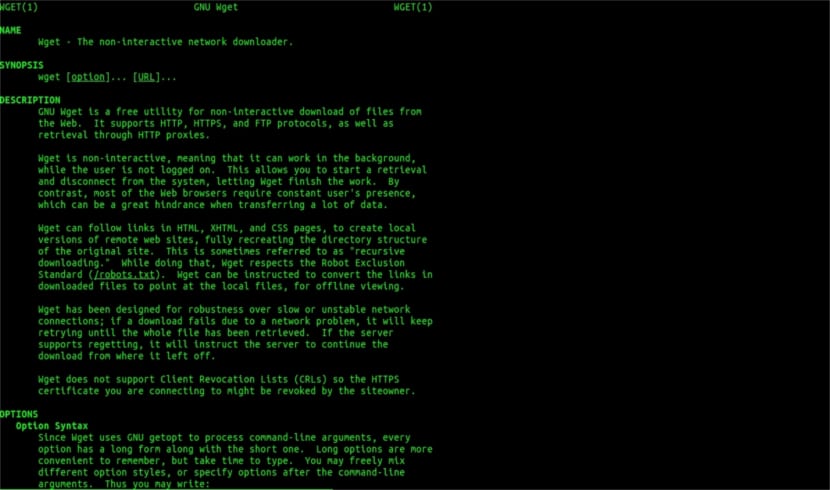

Acestea sunt doar îndrumări generale decât poți face cu Wget. Oricine dorește poate consulta manual online pentru a consulta toate posibilitățile pe care ni le oferă acest minunat manager de descărcare.

În ceea ce privește „Descărcare prin extensie”, am încetat să citesc. Nu poți descărca ceea ce nu știi. Cu excepția cazului în directorul solicitat permite listarea fișierelor și lipsește un index (și ambele trebuie să apară în același timp), ceea ce spuneți nu poate fi făcut. Ce nivel.

Bună ziua Rubén, ignoranța este un pic îndrăzneață.

Ceea ce comentați se poate face cu o simplă comandă pentru Google:

tip de fișier: pdf site:ubunlog.com

În acest exemplu nu există pdf în acest blog, dar schimbați domeniul la sfârșitul paginii web pe care o preferați și veți vedea cât de ușor este să vedeți toate fișierele unui tip de web.

O zi plăcută.

Dar wget nu se conectează la google pentru a găsi fișierele pdf care se află într-o adresă URL. Directorul web trebuie să fie deschis și trebuie să existe o pagină index generată de mod_autoindex sau similar, așa cum spune Rubén Cardenal.

"Această comandă nu funcționează întotdeauna, deoarece este posibil ca unele servere să fi blocat accesul la wget."

Această modificare care a fost introdusă în acest articol, deoarece nu sunt de acord cu el (deși din punct de vedere tehnic este posibil să blocați anumiți agenți web pentru solicitări de antet http și să returnați un mesaj 403 „nepermis”) și voi explica de ce:

Toate serverele web Apache (și vorbesc despre un procent considerabil de servere) în mod implicit permit blocarea (excelent articol Wikipedia, citiți: https://es.wikipedia.org/wiki/Glob_(inform%C3%A1tica) .

Aceasta în practică înseamnă, așa cum este specificat de dl. Rubén (și are dreptate), DACĂ NU SUNT FIȘIERE NUMITE „index.php” sau „index.html” (sau chiar pur și simplu numit „index”) serverul va returna în liniște o listă de fișiere și directoare (bineînțeles în formă a unei pagini html cu informațiile ca link web pentru fiecare fișier). MAI MULTE SERVICII WEB DEZACTIVEAZĂ ACEASTA CARACTERISTICĂ PRIN FIȘIERUL .htacces (strict Apache2) PENTRU MOTIVELE SIGURANȚEI.

Iată versatilitatea wget (vezi povestea sa, din nou pe Wikipedia, cea pe care o cunoști cel mai mult: https://es.wikipedia.org/wiki/GNU_Wget ) să analizăm sau să „analizăm” informațiile menționate și să extragem doar extensiile pe care le solicităm.

Acum, în cazul în care acest lucru nu funcționează, dintr-un motiv sau altul, putem încerca alte funcții avansate wget, citez direct în engleză:

Doriți să descărcați toate GIF-urile dintr-un director de pe un server HTTP. Ai încercat să te uiți http://www.example.com/dir/*.gif’, dar asta nu a funcționat deoarece regăsirea HTTP nu acceptă GLOBBING (am pus literele mari). În acest caz, utilizați:

wget -r -l1 –fără părinte -A.gif http://www.example.com/dir/

Mai detaliat, dar efectul este același. '-r -l1' înseamnă recuperarea recursivă (vezi Descărcare recursivă), cu adâncimea maximă de 1. '-no-părinte' înseamnă că referințele la directorul părinte sunt ignorate (vezi Limite bazate pe director) și '-A. gif 'înseamnă să descărcați numai fișierele GIF. „-A« * .gif »” ar fi funcționat și el.

DACĂ RULAȚI ÎN ACEASTĂ MOD Wget va crea un folder pentru noi cu adresa web solicitată în folderul implicit în care lucrăm și va crea subdirectoare dacă este necesar și acolo va plasa, de exemplu, imaginile .gif pe care le cerere.

--------

Oricum, dacă tot nu este posibil să se obțină doar anumite tipuri de fișiere (* .jpg, de exemplu) va trebui să folosim parametrul «–pagini-cerințe» care descarcă toate elementele interne ale unei pagini html (imagini, sunete, css, etc) împreună cu pagina html în sine („–page-requisites” poate fi prescurtată „-p”) și ar fi echivalentul descărcării ceva de genul „mhtml” https://tools.ietf.org/html/rfc2557

Sper că aceste informații vă sunt utile.

Mulțumesc pentru note. Salu2.

Cred că aveți o eroare, primele două linii au aceeași comandă.

Mulțumesc foarte mult, foarte bun tutorial!