I nästa artikel kommer vi att ta en titt på Wget. Det måste sägas att GNU Wget är en gratis verktyg som möjliggör nedladdning av innehåll från webbservrar på ett enkelt och snabbt sätt. Dess namn kommer från World Wide Web (w) och ordet get (på engelska skaffa sig). Detta namn betyder: få från WWW.

Idag finns det dussintals applikationer för att ladda ner filer mycket effektivt. De flesta är baserade på webb- och skrivbordsgränssnitt och är utvecklade för alla operativsystem. Men på Gnu / Linux (det finns också en version för Windows) där är kraftfull nedladdningshanterare av wget-filer. Det anses vara den mest kraftfulla nedladdaren som finns. Stöder protokoll som http, https och ftp.

Ladda ner filer med wget

Ladda ner en fil

Det enklaste sättet att använda detta verktyg är att ladda ner som anger filen Vad vi vill:

wget http://sitioweb.com/programa.tar.gz

Ladda ner med olika protokoll

Som en bra nedladdningshanterare är det möjligt begära mer än en nedladdning åt gången. Vi kan även använda olika protokoll i samma ordning:

wget http://sitioweb.com/programa.tar.gz ftp://otrositio.com/descargas/videos/archivo-video.mpg

Ladda ner efter förlängning

Ett annat sätt att ladda ner flera filer som använder samma tilläggkommer den att använda jokertecken-asterisken:

wget<code class="language-bash" data-lang="bash">-r -A.pdf</code>http://sitioweb.com/*.pdf

Det här kommandot fungerar inte alltid, eftersom vissa servrar kan ha blockerat åtkomst till wget.

Ladda ner en fillista

Om det vi vill är att ladda ner de filer som vi hittar, behöver vi bara spara dem URL i en fil. Vi skapar en lista som heter files.txt och vi kommer att ange namnet på listan till kommandot. Nödvändig placera bara en webbadress per rad inuti files.txt.

Kommandot som vi kommer att använda för att ladda ner listan som skapats och som vi sparar i files.txt kommer att vara följande:

wget -i archivos.txt

Starta om en nedladdning

Om nedladdningen av någon anledning avbröts kommer vi att kunna fortsätt nedladdningen där den slutade använda alternativ c med wget-kommandot:

wget -i -c archivos.txt

Lägg till en logg om nedladdningen

Om vi vill få en logg om nedladdningen, för att kontrollera alla händelser på den måste vi lägga till -o alternativ som det visas i följande:

wget -o reporte.txt http://ejemplo.com/programa.tar.gz

Begränsa nedladdningsbandbredd

I mycket långa nedladdningar kan vi begränsa nedladdningsbandbredd. Detta förhindrar att nedladdningen tar upp hela bandbredden under nedladdningen:

wget -o /reporte.log --limit-rate=50k ftp://ftp.centos.org/download/centos5-dvd.iso

Ladda ner med användarnamn och lösenord

Om vi vill ladda ner från en webbplats där ett användarnamn / lösenord krävs, behöver vi bara använda dessa alternativ:

wget --http-user=admin --http-password=12345 http://ejemplo.com/archivo.mp3

Nedladdningsförsök

Standard, detta program gör 20 försök att upprätta anslutningen och starta nedladdningen, på mycket mättade webbplatser är det möjligt att det inte uppnåddes även med 20 försök. Med alternativ t ökar till fler försök.

wget -t 50 http://ejemplo.com/pelicula.mpg

Ladda ner en webbplats med wget

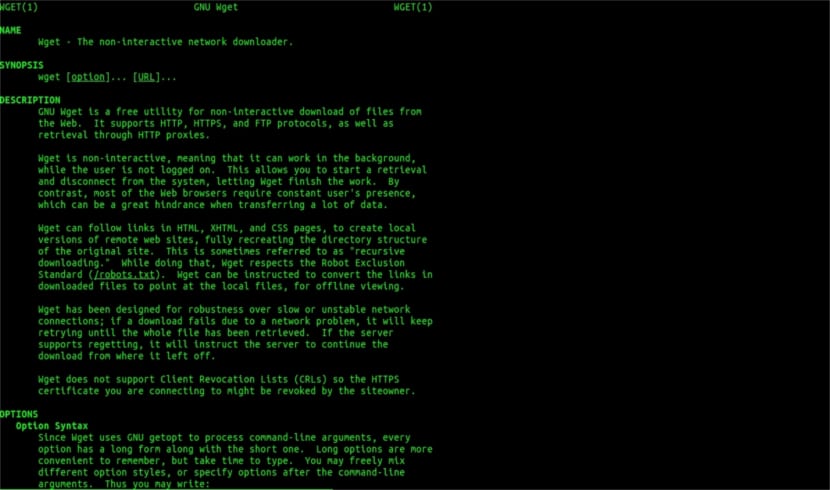

Wget hjälp man

Wget är inte begränsat till bara filnedladdningarVi kommer att kunna ladda ner en hel sida. Vi måste bara skriva något som:

wget www.ejemplo.com

Ladda ner en webbplats och dess extra element

Med alternativ s vi kommer också att ladda ner alla extra element som behövs på sidan såsom stilark, inbyggda bilder etc.

Om vi lägger till alternativ r se laddas ned rekursivt upp till 5 nivåer från webbplatsen:

wget -r www.ejemplo.com -o reporte.log

Konvertera länkar till lokalbefolkningen

Som standard pekar länkar på webbplatsen till adressen för hela domänen. Om vi laddar ner webbplatsen rekursivt och sedan studerar den offline kan vi använda alternativet konvertera länkar som kommer att göra dem till lokala länkar:

wget --convert-links -r http://www.sitio.com/

Få en fullständig kopia av webbplatsen

Vi kommer att få en fullständig kopia av en webbplats. De –Speglingsalternativ är samma som att använda alternativ -r -l inf -N vilket indikerar rekursion på oändlig nivå och erhåller den ursprungliga tidsstämpeln för varje nedladdad fil.

wget --mirror http://www.sitio.com/

Omvandla tillägg

Om du laddar ner hela webbplatsen för att se den offline kan det hända att flera nedladdade filer inte öppnas på grund av tillägg som .cgi, .asp eller .php. Då är det möjligt att ange med –Html-tilläggsalternativ Alla filer konverteras till ett .html-tillägg.

wget --mirror --convert-links --html-extension http://www.ejemplo.com

Dessa är bara allmänna riktlinjer än du kan göra med Wget. Vem vill kan konsultera onlinehandbok att konsultera alla möjligheter som denna underbara nedladdningshanterare erbjuder oss.

När det gäller "Ladda ner efter förlängning" har jag slutat läsa. Du kan inte ladda ner det du inte vet. Om inte den begärda katalogen tillåter listning av filer och saknar ett index (och båda måste förekomma samtidigt), kan du inte göra vad du säger. Vilken nivå.

Hej Rubén, okunnighet är lite vågad.

Vad du kommenterar kan göras med ett enkelt kommando för att google:

filtyp:pdf webbplats:ubunlog.com

I det här exemplet finns det ingen pdf i den här bloggen, men ändra domänen i slutet till webben du föredrar så kommer du att se hur lätt det är att se alla filer på en webbtyp.

Ha en bra dag.

Men wget ansluter inte till google för att hitta pdfs som finns i en webbadress. Webbkatalogen måste vara öppen och det måste finnas en indexsida som genereras av mod_autoindex eller liknande, som Rubén Cardenal säger.

"Det här kommandot fungerar inte alltid, eftersom vissa servrar kan ha blockerat åtkomst till wget."

Detta ändringsförslag som placerades i den här artikeln eftersom jag inte håller med om det (även om det tekniskt sett är möjligt att blockera vissa webbagenter för http-rubrikförfrågningar och returnera ett 403-meddelande "inte tillåtet") och jag kommer att förklara varför:

Alla Apache-webbservrar (och jag pratar om en betydande andel servrar) tillåter som standard globbing (utmärkt Wikipedia-artikel, läs: https://es.wikipedia.org/wiki/Glob_(inform%C3%A1tica) .

Detta innebär i praktiken, som specificerats av herr. Rubén (och han har rätt), OM DET INGEN FIL KALLAS "index.php" eller "index.html" (eller till och med helt enkelt kallas "index") kommer servern tyst att returnera en lista med filer och kataloger (naturligtvis i form på en html-sida med informationen som en webblänk för varje fil). DE FLESTA WEB-SERVERNA INAKTIVERAR DENNA FUNKTION GENOM .htacces-FILEN (strängt taget Apache2) FÖR SÄKERHETSMOTIVER.

Här är mångsidigheten hos wget (se dess historia, igen på Wikipedia, den du känner mest till: https://es.wikipedia.org/wiki/GNU_Wget ) för att analysera eller "analysera" sådan information och endast extrahera de tillägg som vi begär.

Om det här inte fungerar, av en eller annan anledning, kan vi prova andra avancerade wget-funktioner, jag citerar direkt på engelska:

Du vill ladda ner alla GIF-filer från en katalog på en HTTP-server. Du försökte 'wget http://www.example.com/dir/*.gif’, men det fungerade inte eftersom HTTP-hämtning inte stöder GLOBBING (jag sätter stora bokstäver). Använd i så fall:

wget -r -l1 –ingen förälder -A.gif http://www.example.com/dir/

Mer detaljerad, men effekten är densamma. '-r -l1' betyder att hämta rekursivt (se Rekursiv nedladdning), med maximalt djup på 1. '–ingen förälder' betyder att referenser till överordnad katalog ignoreras (se Katalogbaserade gränser) och '-A. gif betyder bara att ladda ner GIF-filerna. '-A «* .gif»' hade också fungerat.

OM du springer på den här sista vägen skapar wget en mapp för oss med den begärda webbadressen i standardmappen där vi arbetar, och den kommer att skapa underkataloger om det behövs och där placerar den till exempel .gif-bilderna som vi begäran.

--------

Men om det fortfarande inte går att få endast vissa typer av filer (* .jpg, till exempel) måste vi använda parametern «–sida-krav" som laddar ner alla interna element på en html-sida (bilder, ljud, css, etc) tillsammans med själva html-sidan ("–page-Requisites" kan förkortas "-p") och det motsvarar att ladda ner något som "mhtml" https://tools.ietf.org/html/rfc2557

Jag hoppas att den här informationen är användbar för dig.

Tack för anteckningarna. Salu2.

Jag tror att du har ett fel, de två första raderna har samma kommando.

Tack så mycket, mycket bra handledning!