Në artikullin vijues do të hedhim një vështrim në Wget. Duhet thënë që GNU Wget është një mjet falas që lejon shkarkimin e përmbajtjes nga serverat e internetit në një mënyrë të thjeshtë dhe të shpejtë. Emri i saj rrjedh nga World Wide Web (w) dhe fjala get (në anglisht) marrë) Ky emër nënkupton: merrni nga WWW.

Sot ka dhjetëra aplikacione për të shkarkuar skedarë në mënyrë shumë efikase. Shumica e tyre janë të bazuara në ndërfaqe në internet dhe desktop dhe janë zhvilluar për të gjitha sistemet operative. Sidoqoftë në Gnu / Linux (ekziston edhe një version për Windows) ekziston menaxher i fuqishëm i shkarkimeve e dosjeve wget. Konsiderohet shkarkuesi më i fuqishëm që ekziston. Mbështet protokollet si http, https dhe ftp.

Shkarkoni skedarë me wget

Shkarkoni një skedar

Mënyra më e thjeshtë për të përdorur këtë mjet është të shkarkoni duke treguar skedarin Çfarë duam:

wget http://sitioweb.com/programa.tar.gz

Shkarkoni duke përdorur protokolle të ndryshme

Si një menaxher i mirë shkarkimesh, është e mundur kërkoni më shumë se një shkarkim në të njëjtën kohë. Ne madje mund të përdorim protokolle të ndryshëm në të njëjtën mënyrë:

wget http://sitioweb.com/programa.tar.gz ftp://otrositio.com/descargas/videos/archivo-video.mpg

Shkarkoni me zgjerim

Një mënyrë tjetër për të shkarkuar shumëfish skedarët që përdorin të njëjtën shtesë, do të përdorë yllin e kartës së egër:

wget<code class="language-bash" data-lang="bash">-r -A.pdf</code>http://sitioweb.com/*.pdf

Kjo komandë nuk funksionon gjithmonë, pasi disa servera mund të kenë bllokuar hyrjen wget.

Shkarkoni një listë të skedarëve

Nëse ajo që duam është të shkarkojmë skedarët që po gjejmë, ne do të duhet vetëm t'i ruajmë ato URL në një skedar. Ne do të krijojmë një listë të quajtur skedarët.txt dhe ne do të tregojmë emrin e listës në komandë. Është e nevojshme vendosni vetëm një url për rresht brenda skedarëve.txt.

Komanda që do të përdorim për të shkarkuar listën e krijuar dhe që ruajmë në skedarët .txt do të jetë e mëposhtme:

wget -i archivos.txt

Rinisni një shkarkim

Nëse për çfarëdo arsye shkarkimi u ndërpre, ne do të jemi në gjendje vazhdoni shkarkimin nga aty ku u ndal duke perdorur opsioni c me komandën wget:

wget -i -c archivos.txt

Shtoni një regjistër në lidhje me shkarkimin

Nëse duam të sigurojmë një regjistër në lidhje me shkarkimin, për të kontrolloni çdo incident mbi të, ne do të duhet të shtojmë -o opsion siç tregohet në vijim:

wget -o reporte.txt http://ejemplo.com/programa.tar.gz

Kufizoni gjerësinë e bandës së shkarkimit

Në shkarkime shumë të gjata mundemi kufizoni bandën e shkarkimit. Me këtë ne do të parandalojmë që shkarkimi të marrë të gjithë gjerësinë e bandës për kohëzgjatjen e shkarkimit:

wget -o /reporte.log --limit-rate=50k ftp://ftp.centos.org/download/centos5-dvd.iso

Shkarkoni me emrin e përdoruesit dhe fjalëkalimin

Nëse duam të shkarkojmë nga një sit ku kërkohet një emër përdoruesi / fjalëkalimi, ne do të duhet të përdorim vetëm këto opsione:

wget --http-user=admin --http-password=12345 http://ejemplo.com/archivo.mp3

Përpjekjet për shkarkim

Default, ky program bën 20 përpjekje për të vendosur lidhjen dhe filloni shkarkimin, në faqet shumë të ngopura është e mundur që edhe me 20 përpjekje nuk është arritur. Me opsioni t rritet në më shumë përpjekje.

wget -t 50 http://ejemplo.com/pelicula.mpg

Shkarkoni një faqe në internet me wget

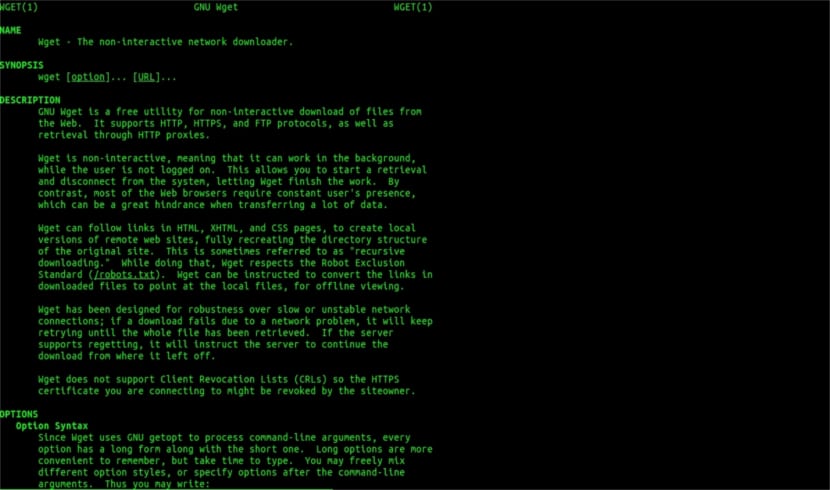

Wget ndihmë njeriu

Wget nuk kufizohet vetëm në shkarkime skedarëshNe do të jemi në gjendje të shkarkojmë një faqe të plotë. Thjesht do të duhet të shkruajmë diçka si:

wget www.ejemplo.com

Shkarkoni një faqe në internet dhe elementet shtesë të saj

Me opsioni f ne gjithashtu do të shkarkoni të gjitha elemente shtesë të nevojshëm në faqe siç janë fletët e stilit, imazhet inline, etj.

Nëse shtojmë opsioni r se do të shkarkojë në mënyrë rekursive deri në 5 nivele nga faqja:

wget -r www.ejemplo.com -o reporte.log

Shndërroni lidhjet në lokale

Si parazgjedhje, lidhjet brenda faqes tregojnë për adresën e të gjithë domenit. Nëse e shkarkojmë faqen në mënyrë rekursive dhe pastaj e studiojmë jashtë linje, mund të përdorim opsioni i konvertimeve-lidhjeve që do t'i shndërrojë ato lidhje lokale:

wget --convert-links -r http://www.sitio.com/

Merrni një kopje të plotë të faqes

Ne do të kemi mundësinë për të marrë një kopje të plotë të një faqe. - opsion pasqyre është e njëjtë me përdorimin e opsionet -r -l inf -N e cila tregon rekursion në nivel të pafund dhe marrjen e vulave origjinale të secilës skedar të shkarkuar.

wget --mirror http://www.sitio.com/

Transformoni zgjatimet

Nëse shkarkoni të gjithë faqen për ta parë atë jashtë linje, disa skedarë të shkarkuar mund të mos hapen, për shkak të shtesave të tilla si .cgi, .asp ose .php. Atëherë është e mundur të tregohet me –Html-opsion shtesë Të gjithë skedarët konvertohen në një shtrirje .html.

wget --mirror --convert-links --html-extension http://www.ejemplo.com

Këto janë vetëm udhëzime të përgjithshme sesa mund të bësh me Wget. Kush dëshiron mund të konsultohet me manual online për të konsultuar të gjitha mundësitë që na ofron ky menaxher i mrekullueshëm i shkarkimeve.

Sa për "Shkarkoni me zgjatje" unë ndalova së lexuari. Ju nuk mund të shkarkoni atë që nuk dini. Në qoftë se drejtoria e kërkuar nuk lejon renditjen e skedarëve dhe nuk ka një indeks (dhe të dy duhet të ndodhin në të njëjtën kohë), ajo që ju thoni nuk mund të bëhet. Çfarë niveli.

Përshëndetje Rubén, injoranca është paksa e guximshme.

Ajo që komentoni mund të bëhet me një komandë të thjeshtë për të google:

lloji i skedarit: faqe pdf:ubunlog.com

Në këtë shembull nuk ka pdf në këtë blog, por ndryshoni domenin në fund të uebit që preferoni dhe do të shihni se sa e lehtë është të shikosh të gjitha skedarët e një lloji të një uebi.

Kalofsh nje dite te mbare.

Por wget nuk lidhet me google për të gjetur pdf-të që janë në një url. Drejtoria e uebit duhet të jetë e hapur dhe duhet të ketë një faqe indeksi të gjeneruar nga mod_autoindex ose të ngjashme, siç thotë Rubén Cardenal.

"Kjo komandë nuk funksionon gjithmonë, pasi disa servera mund të kenë bllokuar hyrjen në wget."

Ky ndryshim që u vendos në këtë nen, sepse unë nuk jam dakord me të (edhe pse teknikisht është e mundur të bllokosh disa agjentë të internetit për kërkesat e header http dhe të kthej një mesazh 403 "nuk lejohet") dhe unë do të shpjegoj pse:

Të gjithë serverat e internetit Apache (dhe unë jam duke folur për një përqindje të konsiderueshme të serverave) si parazgjedhje lejojnë globbing (artikull i shkëlqyeshëm i Wikipedia, lexoni: https://es.wikipedia.org/wiki/Glob_(inform%C3%A1tica) .

Kjo në praktikë do të thotë, siç specifikohet nga z. Rubén (dhe ai ka të drejtë), NFSE NUK KA FILE Q CNDRUAR "index.php" ose "index.html" (apo edhe thjesht quhet "indeks") serveri do të kthejë në heshtje një listë të skedarëve dhe direktorive (natyrisht në formë të një faqe html me informacionin si një lidhje interneti për secilën skedar). SERVERSRAT M M T MBNJN WEB E PAKONOJNIS KIST F TIPAR P THRMES FILE .htacces (duke folur në mënyrë rigoroze Apache2) PASR ARSYE T SEC SIGURIS.

Këtu është shkathtësia e wget (shih historinë e tij, përsëri në Wikipedia, atë që njeh më shumë: https://es.wikipedia.org/wiki/GNU_Wget ) për të analizuar ose "analizuar" informacionin e thënë dhe për të nxjerrë vetëm shtesat që ne kërkojmë.

Tani, në rast se kjo nuk funksionon, për një arsye ose një tjetër, ne mund të provojmë funksione të tjera të përparuara të wget, citoj drejtpërdrejt në anglisht:

Ju dëshironi të shkarkoni të gjitha GIF-të nga një direktori në një server HTTP. Ju provuat 'wget http://www.example.com/dir/*.gif’, por kjo nuk funksionoi sepse rikuperimi i HTTP nuk mbështet GLOBBING (vë shkronjat e mëdha). Në atë rast, përdorni:

wget -r -l1 –jo-prind -A.gif http://www.example.com/dir/

Më shumë fjalëpamëse, por efekti është i njëjtë. '-r -l1' do të thotë të rikuperosh në mënyrë rekursive (shih Shkarkimin rekursiv), me thellësi maksimale prej 1. '-jo-prind' do të thotë që referencat në direktorinë prind nuk merren parasysh (shih Kufijtë e Bazuar në Direktori) dhe '-A. gif 'do të thotë të shkarkosh vetëm skedarët GIF. '-A «* .gif»' do të kishte funksionuar gjithashtu.

NESE VENI N TH KIST MAYNYR TAST FUNDIT wget do të krijojë një dosje për ne me adresën e kërkuar të internetit në dosjen e paracaktuar ku po punojmë, dhe do të bëjë nëndirektori nëse është e nevojshme dhe aty do të vendosen, për shembull, imazhet .gif që ne kërkesë.

--------

Sidoqoftë nëse ende nuk është e mundur të merren vetëm lloje të caktuara të skedarëve (* .jpg, për shembull) ne do të duhet të përdorim parametrin «–faqe-kërkesa» që shkarkon të gjithë elementët e brendshëm të një faqe html (imazhe, tinguj, css, etj) së bashku me vetë faqen html ("–page-requisites" mund të shkurtohet "-p") dhe kjo do të ishte ekuivalente e shkarkimit të diçkaje si "mhtml" https://tools.ietf.org/html/rfc2557

Shpresoj që ky informacion të jetë i dobishëm për ju.

Faleminderit për shënimet. Salu2

Mendoj se keni një gabim, dy rreshtat e parë kanë të njëjtën komandë.

Faleminderit shumë, tutorial shumë të mirë!